人工智能(AI)技術飛速發展,以其強大的數據處理、模式識別和內容生成能力,深刻改變了學術研究的方式。與此全球范圍內涌現出大量公開、免費的人工智能公共數據集平臺,為研究者提供了前所未有的便利。在技術進步與資源開放的積極敘事之下,一股暗流正在涌動:AI技術、公開數據集與日益產業化的“論文工廠”三者之間,正形成一種危險的“協同效應”,導致科研領域,尤其是部分新興交叉學科,面臨著劣質論文泛濫的嚴峻挑戰。

一、 技術便利與資源開放的雙刃劍

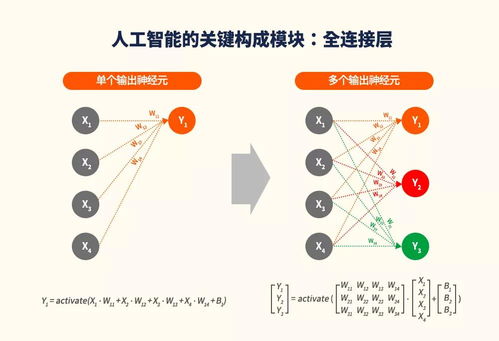

人工智能的“生產力革命”:以自然語言處理(NLP)和大型語言模型(LLM)為代表的AI工具,能夠輔助研究者快速進行文獻綜述、數據分析、圖表生成甚至初稿撰寫。這原本是提升科研效率的福音。其“一鍵生成”的便捷性,也大大降低了學術不端行為的門檻。一些工具可以被輕易用于捏造數據、洗稿甚至批量生產結構完整但內容空洞的論文框架。

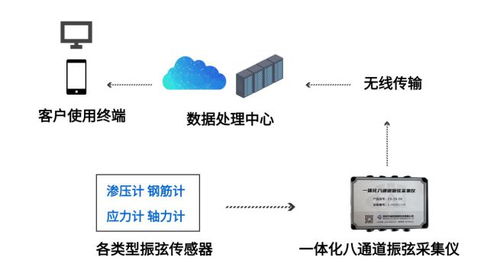

公共數據平臺的“無門檻供給”:像Kaggle、UCI Machine Learning Repository、政府開放數據門戶等平臺,匯集了海量的結構化與非結構化數據。這極大地促進了研究的可重復性和跨領域探索。但問題在于,這些數據集的獲取過于容易,且同質化嚴重。許多缺乏嚴謹科學問題、僅以“應用某個模型在某個公開數據集上取得微幅提升”為目標的低價值研究得以滋生。研究者可以繞過耗時費力的原始數據收集與清洗過程,直接進入“調參-跑分-寫論文”的流水線模式。

二、 “論文工廠”的產業化運作

“論文工廠”是指以營利為目的,規模化、流水線式偽造或代寫學術論文的非法組織。AI技術和公共數據集的普及,為這類工廠提供了完美的“生產原料”和“自動化工具”。

- 模板化生產:利用公開數據集中幾個熱門數據集(如MNIST, CIFAR-10, ImageNet子集),套用幾種經典或稍加修改的AI模型(如ResNet, BERT變體),便可以批量制造出成千上萬篇“配方論文”。其結構高度雷同:引言套用固定模板,方法部分描述輕微改動,實驗部分使用公開數據跑出結果,討論與結論泛泛而談。

- 數據偽造與篡改變得“智能化”:AI工具可以幫助“論文工廠”更逼真地偽造實驗數據、生成看似合理的統計圖表,甚至自動規避常見的數據完整性檢查點,使得欺詐行為更加隱蔽,難以被期刊編輯和審稿人一眼識破。

- 洗稿與規避查重:利用AI改寫工具,可以快速對已有論文進行 paraphrasing,降低文字重復率,但核心思想與邏輯并未改變,生產出大量的“學術垃圾”。

三、 三方“攜手”下的惡性循環

人工智能、公共數據集與論文工廠之間,形成了一個加速劣質論文產生的閉環:

- AI降低生產成本 → 論文工廠產能大增。

- 公共數據集提供標準原料 → 論文工廠無需原創數據,生產標準化、速度快。

- 海量劣質論文涌向市場 → 尤其是一些收取高額版面費、審稿不嚴的“掠奪性期刊”或會議,為其提供了出口。

- 低質量發表獲得短期利益(如畢業、晉升、項目結題)→ 激勵更多個體或機構尋求工廠服務,進一步滋養論文工廠。

- 學術界信噪比急劇下降 → 真正有價值的研究被淹沒,科研人員檢索和甄別文獻的負擔加重,損害了整個學術生態的誠信與創新活力。

四、 應對策略與未來展望

面對這一挑戰,堵不如疏,需要學術界、出版界和技術平臺共同努力,構建新的治理與過濾機制:

- 學術評價體系改革:推動從“唯論文數量、唯期刊等級”向重視研究原創性、實際貢獻和長期影響力的多元評價體系轉變。鼓勵數據收集、算法創新、系統構建等多樣化的科研產出。

- 出版與評審機制強化:期刊和會議應要求作者提供更詳細的代碼、數據(特別是處理流程)和實驗日志,強制進行可重復性驗證。推廣“注冊報告”出版模式,在研究開始前就審核其科學價值與方法,而非僅關注結果。利用AI工具本身來輔助檢測論文中的異常模式、圖像篡改和文本相似性。

- 數據平臺的責任升級:公共數據平臺可以引入更完善的數據溯源、使用追蹤和貢獻評估機制。對于被大量用于低價值研究的“過熱”數據集,平臺可以發出提示,鼓勵研究者關注數據質量本身或尋找更具挑戰性的新數據。

- 研究者自律與教育:加強科研倫理教育,讓新一代研究者深刻理解學術誠信的底線。倡導負責任地使用AI工具,明確其“輔助”而非“替代”的定位。

###

人工智能與公共數據平臺本是推動科研民主化、加速科學發現的偉大工具。但當它們與急功近利的學術評價生態和非法牟利的論文工廠結合時,便產生了扭曲的“化學反應”。破解這一困局,關鍵在于切斷其中的利益鏈條,重建以質量為本的科研文化。技術本身無善惡,取決于使用它的人與制度。唯有讓技術回歸“服務真問題、促進真創新”的初心,才能避免學術圈陷入一場由算法和數據驅動的“垃圾泛濫”危機。